“虚拟现实技术与内容制作”版本间的差异

Gaoying324(讨论 | 贡献) |

(→学习日志) |

||

| (10位用户的61个中间修订版本未显示) | |||

| 第1行: | 第1行: | ||

| + | =课号= | ||

| + | |||

| + | 01510263 | ||

=教学说明= | =教学说明= | ||

==教学团队== | ==教学团队== | ||

| − | + | [[设计与原型实验室]] | |

| + | 王德宇,金晖 | ||

| − | [ | + | [[互联网+实验室|智能系统实验室]] |

| − | + | 陈震、章屹松、王蓓蓓、马晓东、高英 | |

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

==上课地点== | ==上课地点== | ||

| − | |||

| − | + | 李兆基科技大楼B137 | |

| − | + | ||

| − | + | ||

==服务器== | ==服务器== | ||

| + | |||

软件资源服务器 | 软件资源服务器 | ||

| − | \\ | + | 本课程用到的软件和素材存放在服务器,使用方法,在资源管理器中,或Win+r(同时按下Win键和R键)调出运行命令窗口,写入以下内容: |

| + | |||

| + | \\101.6.160.40 用户名/密码:vr/vr123456 目录 vr\工程体验vr课程软件(素材) | ||

课程作业服务器 | 课程作业服务器 | ||

| − | \\ | + | \\101.6.160.39\vrdemo 用户名/密码:vr/vr123456 |

| + | |||

| + | 作业上传地址 | ||

| − | + | \\net.icenter.tsinghua.edu.cn\vrdemo 用户名/密码:vr/vr123456 | |

| − | + | 作业浏览地址 | |

| − | + | http://net.icenter.tsinghua.edu.cn/vr | |

| − | =VR技术定义= | + | =虚拟现实技术概览= |

| − | 利用电脑或其他智能计算设备模拟产生一个三度空间的虚拟世界,提供用户关于视觉、听觉、触觉等感官的模拟,让用户如同身历其境一般。 | + | |

| + | ==VR技术定义== | ||

| + | |||

| + | 利用电脑或其他智能计算设备模拟产生一个三度空间的虚拟世界,提供用户关于视觉、听觉、触觉等感官的模拟,让用户如同身历其境一般。 | ||

VR是目前全球公认的下一代计算平台。每一代计算平台的出现都给科技行业以及跟计算机、互联网相关的所有行业带来天翻地覆的变化。 | VR是目前全球公认的下一代计算平台。每一代计算平台的出现都给科技行业以及跟计算机、互联网相关的所有行业带来天翻地覆的变化。 | ||

| − | |||

| − | |||

==虚拟现实设备== | ==虚拟现实设备== | ||

===HTC Vive=== | ===HTC Vive=== | ||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | + | Vive由HTC和Valve联合开发。借助精准的移动追踪和自然的操控手柄手势,体验空间定位游戏。借助前置摄像头,在需要时打量一下真实世界。无需摘下头戴装置即可打开应用程序和游戏。这是完全的沉浸式虚拟现实体验。 | |

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | 2015年3月2日巴塞罗拉世界移动通信大会(2015)举行期间,HTC发布消息推出了一款VR游戏头盔。这款头盔名为HTC Vive,屏幕刷新率为90Hz,搭配两个无线控制器,并具备手势追踪功能。 | |

| − | + | HTC Vive通过以下三个部分致力于给使用者提供沉浸式体验:一个头戴式显示器、两个单手持控制器、一个能于空间内同时追踪显示器与控制器的定位系统(Lighthouse)。 | |

| − | + | 在头显上,HTC Vive开发者版采用了一块OLED屏幕,单眼有效分辨率为1200 x 1080,双眼合并分辨率为2160 x 1200。2K分辨率大大降低了画面的颗粒感,用户几乎感觉不到纱门效应;并且能在佩戴眼镜的同时戴上头显,即使没有佩戴眼镜,400度左右近视依然能清楚看到画面的细节。画面刷新率为90Hz,今年3月份的数据显示延迟为22ms,实际体验几乎零延迟,也不觉得恶心和眩晕。 | |

| + | 控制器定位系统Lighthouse采用的是Valve的专利,它不需要借助摄像头,而是靠激光和光敏传感器来确定运动物体的位置,也就是说HTC Vive允许用户在一定范围内走动。这是它与另外两大头显Oculus Rift和PS VR的最大区别。 | ||

| + | ===Google Daydream=== | ||

| − | + | Google Daydream:在 Google I/O 2016上,Google VR方面的负责人Clay Bavor表示,过去开发者们一共开发出了大约5000万款VR应用,他们认为移动VR才是VR的未来,于是推出了一个名为「Daydream」的VR平台。这个平台由三部分组成:核心的Daydream-Ready手机和其操作系统,配合手机使用的头盔和控制器,以及支持Daydream平台生态的应用。 | |

| − | + | Daydream和Cardboard有一个共同点是都依靠移动操作系统——特别是Android;Daydream和Cardboard还有一个共同点是开放性,规格都是第三方能使用的。Daydream将VR从底层到UI全部串联,在系统端保证20ms内的延迟性能和对开发者友好的系统优化。这一切虽然看起来很美,但实际上是理所应当:Gear VR通过深度定制的Android系统,结合算法将延时降到20毫秒,成为当前体验最好的移动VR设备。紧接着一体机的风潮开始建立,摆脱了手机限制的一体机设备也同样能够达到20毫秒内的延时。 | |

| − | + | 而VR mode的应用和Google Play部署VR也是Google在不久之后提供庞大用户平台的基本要求之一。Google的VR控制器,虽然它依旧是采用了「手柄」的概念(与HTC Vive类似),但是它却不同于HTC Vive的基于Base Station的激光定位——一个独立的的手柄是如何能够与头显进行联动? | |

| − | + | 目前普遍的说法是这个控制器无法定位,只能测量转动信息。基于角度追踪的设备或许是VR移动控制器的最佳解决方案。今天的I/O大会上或许出现新的一体机或者移动VR盒子时,Google却要指引开发者深挖交互和硬件性能。如今,无线手柄已然成为VR的最佳解决方案,有了这一模板的出现,在不久后,我们一定能见到类似的配件或者产品。 | |

| − | + | ===Oculus Rift=== | |

| + | Oculus Rift是一款为电子游戏设计的头戴式显示器。Oculus Rift具有两个目镜,每个目镜的分辨率为640×800,双眼的视觉合并之后拥有1280×800的分辨率。并且具有陀螺仪控制的视角是这款游戏产品一大特色,这样一来,游戏的沉浸感大幅提升。Oculus Rift可以通过DVI、HDMI、Micro USB接口连接电脑或游戏机。Oculus Rift是一款虚拟现实设备。2016年7月13日,Oculus宣布即将为所有预定Oculus Rift虚拟现实头盔的用户发货,并且所有工作将在2到4个工作日内完成。 | ||

| − | + | 特色:这是一款虚拟现实显示器,能够使使用者身体感官中“视觉”的部分如同进入游戏中,向《黑客帝国》中所展示的技术迈出了第一步。该设备与索尼HMZ系列为代表的头戴显示设备有较大区别,Oculus Rift提供的是虚拟现实体验,戴上后几乎没有“屏幕”这个概念,用户看到的是整个世界。设备支持方面,开发者已有Unity3D、Source引擎、虚幻4引擎提供官方开发支持。 | |

| − | + | ===Samsung GearVR=== | |

| − | + | Gear VR是三星电子和Facebook旗下的虚拟现实设备公司Oculus VR共同推出新版的虚拟现实头盔。该产品于2015年9月24日推出,需要与三星电子在2015年推出的Galaxy系列设备联合使用。2016年1月22日,Gear VR开售。与上一代产品Innovator相比,新一代的Gear VR重量减轻了22%,而且“更加舒适”。 | |

| − | + | Gear VR包括了一个触控板、一个后置按钮和监测加速和陀螺仪位置的运动传感器。不过该设备依旧需要智能手机的高清晰屏幕进行配合。智能手机通过Micro USB接口被连接到头盔上。 | |

| − | + | ===乐视超级 VR=== | |

| − | + | 乐视超级VR:乐视超级头盔的外观还是近似于目前常见的VR眼镜那般,包含了带有显示模块的主机、头带以及连接线三部分,前面的渐变荧光色的使用让乐视超级头盔看上去更像是一副滑雪护目镜。乐视超级头盔的尺寸是173.4×114.8×94.6mm,放进普通的双肩包还是很简单的。在连接线的旁边就是3.5mm的耳机接孔,当乐视超级头盔连接上手机播放视频时,用户就可以直接通过乐视超级头盔连接音响设备了。而这条连接线则是在末端分为两条,一条是Type-C接口,负责链接乐视超级手机;另一条则是USB线,负责供电。 | |

| − | + | 值得一提的是,相对于乐视超级头盔体积的便携,这条供电的USB线支持5V供电,也就是说你可以使用手机充电器、移动电源等常见设备为其供电,算是便携性的一个加成。 | |

| − | + | 注:目前乐视超级头盔的测试版,接口为Type-C,仅支持乐视超级手机。而Micro USB版本正在开发当中,基础上将支持所有第三方手机。 | |

| − | === | + | ===PlayStation VR=== |

| − | + | (待添加) | |

| − | + | =全景VR制作= | |

| − | == | + | ==摄像器材== |

| − | + | Cannon 6D,装配8.5mm鱼眼镜头,全景云台。 | |

| − | + | ||

| − | = | + | ==环物摄像技术== |

| − | + | 焦距选f/16,光圈选择为8mm,固定光圈,通过调整快门速度改变曝光。 | |

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

==实战拍摄== | ==实战拍摄== | ||

| − | + | 选定场地后,调整曝光和对焦。 | |

| − | + | ||

| − | + | 先选择自动对焦,找准对焦位置后轻轻长按快门同时改为手动对焦;然后实拍几张以确定正常拍摄的曝光值; | |

| − | + | 确定好后调整为HDR模式,共拍摄30张图片: | |

| − | + | * 水平60度分隔以HDR模式共拍摄 6 * 3 = 18 张。 | |

| + | * 垂直90度分隔,拍摄 2 * 3 = 6 张。 | ||

| + | * 补地照片 2 * 3 = 6 张(水平夹角60度侧补地和收起三脚架垂直补地)。注意挪动三脚架之前放好标记纸牌,拍摄补地照片前收回纸牌。 | ||

| − | + | HDR模式拍摄顺序为正常,过曝光,欠曝光照片。 | |

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ==全景图制作== | |

| − | + | 第一步,基于PTGui拼接全景图; | |

| − | + | 第二步,基于Krpanno生成浏览器预览VR版本,用手机浏览器在VR眼镜中观看。 | |

| − | + | ===PTGui=== | |

| − | + | 打开PTGui缝合软件,先导入24张HDR模式照片(不含补地照片),缝合后再导入3张侧补地照片,完成导入与link操作后进行mask操作和Control Point对接。可以适当及进行垂直线与白平衡等内容的校正,预览无误后即可导出全景图片。 | |

| − | + | ||

| − | + | ||

| − | + | # 导入素材——进入软件页面,点击「Load images...」按钮,导入要合成的一组全景图片,一般为24张,水平每60°一组三张,水平6组,天地各一组,按顺序导入。 | |

| + | [[文件:Ptgui1.jpg|500px|缩略图|居中|导入素材]] | ||

| − | + | # 对齐图像 选择Align images 按钮,将第一步导入的24个图像对齐拼接为一个全景图, 在弹出对话框中选择第一行 | |

| − | + | ||

| − | + | ||

| − | |||

| + | [[文件:Align.PNG|500px|缩略图|居中|对齐]] | ||

| − | |||

| − | + | # 添加补地 | |

| − | + | # 蒙板 | |

| + | # 关键控制点 | ||

| + | # 蒙板、优化 | ||

| + | # 生成全景图 | ||

| + | # 保存图片 | ||

| − | |||

| − | |||

| − | |||

| − | + | [[文件:Mask.PNG|500px|缩略图|居中|Mask Point]] | |

| − | [ | + | |

| − | + | [[文件:Opt2.png|缩略图|居中|擦除蒙版]] | |

| + | [[文件:Ptgui22.jpg|500px|缩略图|居中|保存图片]] | ||

| + | ===Krpano=== | ||

| − | + | Krpano是一个可以方便的将全景图制作成其他形式图片的工具,以.bat批处理的形式提供转换,方法是将要转换的图片,直接拖拽到相应的程序即可。 | |

| − | + | ||

| − | + | ||

| − | + | PANO指的是标准全景; | |

| − | + | VTOUR是全景漫游; | |

| + | MULTIRES指的是渐进分辨率,没有尺寸及像素限制; | ||

| + | NORMAL是生成尺寸最大为2200的标准全景图; | ||

| + | 实现特效主要是对vtour文件夹下的html和xml文档通过notepad++进行编程; | ||

| + | 具体操作可以参考krpano官网的相关事例教程,添加静态和动态图片视频音频等内容,以及相关互动内容。 | ||

| − | + | 需注意手机VR内容需要就陀螺仪控制程序进行相关处理。 | |

| − | + | 通过以上方法生成的文件存放在图片目录下的Vtour目录中,可以将这个目录上传到服务器,放在\\101.6.160.39\vrdemo\ 目录下,并且将默认的文件名tour.html,改名为index.html,就可以通透实验室主页观看你的作品了。 | |

| − | + | ||

| − | + | 作业上传地址 | |

| − | + | \\net.icenter.tsinghua.edu.cn\vrdemo 用户名/密码:vr/vr123456 | |

| − | + | 作业浏览地址 | |

| − | + | http://net.icenter.tsinghua.edu.cn/vr | |

| − | == | + | =全景视频VR= |

| − | + | ||

| − | + | ==全景视频拍摄== | |

| − | + | ===摄像器材=== | |

| − | + | 高端全景摄像机: | |

| − | + | * NEXT VR | |

| − | + | * Upano J2VR | |

| + | * OZO(by Nokia)[https://ozo.nokia.com/ OZO] | ||

| + | * ODYSSEY + JUMP | ||

| − | + | 中低端全景摄像机: | |

| − | + | * Gopro OMNI | |

| + | * 360 HEROS | ||

| + | * 德图相机F4 [http://cam.detu.com/zh/f4 Detu] | ||

| + | * 完美幻境 Eyesir 4K VR全景相机 [http://www.perfant.com/ Eyesir] | ||

| − | + | ===制作软件=== | |

| − | + | Kolor Autopano Video Pro | |

| + | # 缝合 AUP | ||

| + | # 精调 APG | ||

| − | == | + | ==全景视频拼接== |

| − | + | '''第一步:视频软件拼接''' | |

| − | + | ||

| + | Kolor Autopano Video Pro | ||

| + | * 将不同摄像机中的视频导入软件 | ||

| + | * 寻找视频的同步点。(拍摄时候的同步:最常用的如声音同步,或者快速旋转摄像头的图像同步,让拍摄物体短时间同时出现在几个摄像头中) | ||

| + | *# 在软件中人工手动寻找声音同步 | ||

| + | *# 使用Adobe Premiere Pro CC自动寻找同步,把计算出来相差的帧数填入到Kolor Autopano Video Pro中 | ||

| + | * 生成有地(三脚架)的拼接视频。 | ||

| − | + | '''第二步:视频缝合''' | |

| − | + | ||

| − | + | 地面(三脚架)处理软件:Kolor Autopano Giga | |

| − | + | 该软件用作图片的缝合处理。合理运用下述菜单: | |

| + | * 自动水平 | ||

| + | * 垂直线条工具 | ||

| + | * 自动颜色工具 | ||

| − | + | 对于地,可以采用PhotoShop擦除三脚架。将PS好的地面截取出来后,导入Kolor Autopano Giga融合。 | |

| − | + | '''第三步:生成最后视频''' | |

| − | + | ||

| − | + | 将第二步的输出导入到Kolor Autopano Video Pro,得到合成的视频。 | |

| − | + | ==实战拍摄== | |

| − | + | 拍摄分为4组,每组一部摄像机。 | |

| − | + | 分别使用了小蚁的六目相机,detu 4目,完美幻境摄像机。 | |

| − | + | ||

| − | + | ||

| − | + | 每人的拍摄时长约为40秒钟。 | |

| − | + | ==全景视频剪辑和调色== | |

| − | + | ===剪辑=== | |

| − | + | 使用Adobe Premiere Pro CC软件进行视频的剪辑,在“序列”(sequence)窗口中导入素材(以及配乐),通过拖拽视频条,可以调整播放的位置,或者两个视频条部分重叠,另在“项目”窗口,选择合适视频过渡效果,比如3D、划像、擦除等,达到两个视频内容叠化效果。 | |

| − | + | 在效果的菜单里,有多种的剪辑方式可选,包括: | |

| + | * 音频效果 | ||

| + | * 音频过渡 | ||

| + | * 视频效果 | ||

| + | * 视频过渡 | ||

| + | * 色调调整 | ||

| − | + | 还可以使用小行星的效果。 | |

| + | ===调色=== | ||

| − | + | 在Adobe Premiere Pro CC中可以调色,相比较DaVinci Resolve功能更全。 | |

| − | + | DaVinci包含媒体、编辑、色彩、输出四大功能区。素材导入到媒体池中,在编辑区拖入到时间序列。把时间条移到对应的视频区域,就可以进入色彩菜单进行调整。 | |

| − | + | * 节点调节 | |

| + | * 一级调色(全局),二级调色(局部) | ||

| + | * 示波器(分量图、直方图、矢量图等) | ||

| − | + | =HTC Vive VR实战= | |

| − | + | ==SteamVR== | |

| − | + | SteamVR是由Valve开发的VR应用平台,可以在Steam中下载。 | |

| − | + | 安装SteamVR后,需要连接HTC Vive设备到PC,完成硬件识别和房间设置后才能使用HTC Vive。 | |

| + | ==Unity3D技术== | ||

| + | (待添加) | ||

| − | == | + | ==在Unity3D中添加HTC Vive支持== |

| − | + | 其支持是作为一个Assets包引入Unity的,下载地址为: | |

| + | [https://www.assetstore.unity3d.com/en/#!/content/32647 Unity3d assetstore] | ||

| − | + | 默认需要在Unity中打开并下载,得到的文件会存放在Unity自己设定的目录中,无法直接获取。具体的位置依系统不同而改变,应当使用搜索引擎获取具体位置。 | |

| − | + | 在Unity项目中导入该Assets,在Unity项目的主视角摄像头上绑定该包提供的Steam_Camera脚本,就可以实现视角和头盔的绑定。这样,一个最简单的VR项目就可以完成了。(手柄的互动等其他高级功能有待添加) | |

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | 对于Unity没有经验的人可以参考这份文档: | |

| − | + | [http://oa6msg2ci.bkt.clouddn.com/%E8%B6%85%E7%AE%80Unity%E9%A1%B9%E7%9B%AE.docx 超简Unity3D项目] | |

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | 它提供了一个从「安装Unity」到「建立简单的VR观察者项目」的操作流程 | |

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | == | + | =课程分组= |

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | [[虚拟现实VR-课程分组 | 课程分组]] | |

| − | == | + | =学习日志= |

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | [[虚拟现实VR-学生学习日志 | 学习日志]] | |

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | [[虚拟现实VR-实验室探究课-学生学习日志 | 实验室探究课-学习日志]] | |

| − | == | + | =成果展示= |

| − | + | ||

| − | + | [http://net.icenter.tsinghua.edu.cn/vr iCenter-VR] | |

| − | + | [http://net.icenter.tsinghua.edu.cn/vr/vr-demo VR-Demo] | |

| − | + | [http://net.icenter.tsinghua.edu.cn/vr/vr-video VR-Video] | |

| − | + | =参考文献= | |

| + | The VR Book: Human-Centered Design for Virtual Reality | ||

| + | [http://dl.acm.org/citation.cfm?id=2792790 VR Book] | ||

| − | + | Open Source Virtual Reality | |

| − | + | [https://osvr.github.io OSVR] | |

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

| − | + | ||

2019年8月7日 (三) 10:57的最后版本

课号

01510263

教学说明

教学团队

设计与原型实验室 王德宇,金晖

陈震、章屹松、王蓓蓓、马晓东、高英

上课地点

李兆基科技大楼B137

服务器

软件资源服务器

本课程用到的软件和素材存放在服务器,使用方法,在资源管理器中,或Win+r(同时按下Win键和R键)调出运行命令窗口,写入以下内容:

\\101.6.160.40 用户名/密码:vr/vr123456 目录 vr\工程体验vr课程软件(素材)

课程作业服务器

\\101.6.160.39\vrdemo 用户名/密码:vr/vr123456

作业上传地址

\\net.icenter.tsinghua.edu.cn\vrdemo 用户名/密码:vr/vr123456

作业浏览地址

http://net.icenter.tsinghua.edu.cn/vr

虚拟现实技术概览

VR技术定义

利用电脑或其他智能计算设备模拟产生一个三度空间的虚拟世界,提供用户关于视觉、听觉、触觉等感官的模拟,让用户如同身历其境一般。

VR是目前全球公认的下一代计算平台。每一代计算平台的出现都给科技行业以及跟计算机、互联网相关的所有行业带来天翻地覆的变化。

虚拟现实设备

HTC Vive

Vive由HTC和Valve联合开发。借助精准的移动追踪和自然的操控手柄手势,体验空间定位游戏。借助前置摄像头,在需要时打量一下真实世界。无需摘下头戴装置即可打开应用程序和游戏。这是完全的沉浸式虚拟现实体验。

2015年3月2日巴塞罗拉世界移动通信大会(2015)举行期间,HTC发布消息推出了一款VR游戏头盔。这款头盔名为HTC Vive,屏幕刷新率为90Hz,搭配两个无线控制器,并具备手势追踪功能。

HTC Vive通过以下三个部分致力于给使用者提供沉浸式体验:一个头戴式显示器、两个单手持控制器、一个能于空间内同时追踪显示器与控制器的定位系统(Lighthouse)。

在头显上,HTC Vive开发者版采用了一块OLED屏幕,单眼有效分辨率为1200 x 1080,双眼合并分辨率为2160 x 1200。2K分辨率大大降低了画面的颗粒感,用户几乎感觉不到纱门效应;并且能在佩戴眼镜的同时戴上头显,即使没有佩戴眼镜,400度左右近视依然能清楚看到画面的细节。画面刷新率为90Hz,今年3月份的数据显示延迟为22ms,实际体验几乎零延迟,也不觉得恶心和眩晕。

控制器定位系统Lighthouse采用的是Valve的专利,它不需要借助摄像头,而是靠激光和光敏传感器来确定运动物体的位置,也就是说HTC Vive允许用户在一定范围内走动。这是它与另外两大头显Oculus Rift和PS VR的最大区别。

Google Daydream

Google Daydream:在 Google I/O 2016上,Google VR方面的负责人Clay Bavor表示,过去开发者们一共开发出了大约5000万款VR应用,他们认为移动VR才是VR的未来,于是推出了一个名为「Daydream」的VR平台。这个平台由三部分组成:核心的Daydream-Ready手机和其操作系统,配合手机使用的头盔和控制器,以及支持Daydream平台生态的应用。

Daydream和Cardboard有一个共同点是都依靠移动操作系统——特别是Android;Daydream和Cardboard还有一个共同点是开放性,规格都是第三方能使用的。Daydream将VR从底层到UI全部串联,在系统端保证20ms内的延迟性能和对开发者友好的系统优化。这一切虽然看起来很美,但实际上是理所应当:Gear VR通过深度定制的Android系统,结合算法将延时降到20毫秒,成为当前体验最好的移动VR设备。紧接着一体机的风潮开始建立,摆脱了手机限制的一体机设备也同样能够达到20毫秒内的延时。

而VR mode的应用和Google Play部署VR也是Google在不久之后提供庞大用户平台的基本要求之一。Google的VR控制器,虽然它依旧是采用了「手柄」的概念(与HTC Vive类似),但是它却不同于HTC Vive的基于Base Station的激光定位——一个独立的的手柄是如何能够与头显进行联动?

目前普遍的说法是这个控制器无法定位,只能测量转动信息。基于角度追踪的设备或许是VR移动控制器的最佳解决方案。今天的I/O大会上或许出现新的一体机或者移动VR盒子时,Google却要指引开发者深挖交互和硬件性能。如今,无线手柄已然成为VR的最佳解决方案,有了这一模板的出现,在不久后,我们一定能见到类似的配件或者产品。

Oculus Rift

Oculus Rift是一款为电子游戏设计的头戴式显示器。Oculus Rift具有两个目镜,每个目镜的分辨率为640×800,双眼的视觉合并之后拥有1280×800的分辨率。并且具有陀螺仪控制的视角是这款游戏产品一大特色,这样一来,游戏的沉浸感大幅提升。Oculus Rift可以通过DVI、HDMI、Micro USB接口连接电脑或游戏机。Oculus Rift是一款虚拟现实设备。2016年7月13日,Oculus宣布即将为所有预定Oculus Rift虚拟现实头盔的用户发货,并且所有工作将在2到4个工作日内完成。

特色:这是一款虚拟现实显示器,能够使使用者身体感官中“视觉”的部分如同进入游戏中,向《黑客帝国》中所展示的技术迈出了第一步。该设备与索尼HMZ系列为代表的头戴显示设备有较大区别,Oculus Rift提供的是虚拟现实体验,戴上后几乎没有“屏幕”这个概念,用户看到的是整个世界。设备支持方面,开发者已有Unity3D、Source引擎、虚幻4引擎提供官方开发支持。

Samsung GearVR

Gear VR是三星电子和Facebook旗下的虚拟现实设备公司Oculus VR共同推出新版的虚拟现实头盔。该产品于2015年9月24日推出,需要与三星电子在2015年推出的Galaxy系列设备联合使用。2016年1月22日,Gear VR开售。与上一代产品Innovator相比,新一代的Gear VR重量减轻了22%,而且“更加舒适”。

Gear VR包括了一个触控板、一个后置按钮和监测加速和陀螺仪位置的运动传感器。不过该设备依旧需要智能手机的高清晰屏幕进行配合。智能手机通过Micro USB接口被连接到头盔上。

乐视超级 VR

乐视超级VR:乐视超级头盔的外观还是近似于目前常见的VR眼镜那般,包含了带有显示模块的主机、头带以及连接线三部分,前面的渐变荧光色的使用让乐视超级头盔看上去更像是一副滑雪护目镜。乐视超级头盔的尺寸是173.4×114.8×94.6mm,放进普通的双肩包还是很简单的。在连接线的旁边就是3.5mm的耳机接孔,当乐视超级头盔连接上手机播放视频时,用户就可以直接通过乐视超级头盔连接音响设备了。而这条连接线则是在末端分为两条,一条是Type-C接口,负责链接乐视超级手机;另一条则是USB线,负责供电。

值得一提的是,相对于乐视超级头盔体积的便携,这条供电的USB线支持5V供电,也就是说你可以使用手机充电器、移动电源等常见设备为其供电,算是便携性的一个加成。

注:目前乐视超级头盔的测试版,接口为Type-C,仅支持乐视超级手机。而Micro USB版本正在开发当中,基础上将支持所有第三方手机。

PlayStation VR

(待添加)

全景VR制作

摄像器材

Cannon 6D,装配8.5mm鱼眼镜头,全景云台。

环物摄像技术

焦距选f/16,光圈选择为8mm,固定光圈,通过调整快门速度改变曝光。

实战拍摄

选定场地后,调整曝光和对焦。

先选择自动对焦,找准对焦位置后轻轻长按快门同时改为手动对焦;然后实拍几张以确定正常拍摄的曝光值;

确定好后调整为HDR模式,共拍摄30张图片:

- 水平60度分隔以HDR模式共拍摄 6 * 3 = 18 张。

- 垂直90度分隔,拍摄 2 * 3 = 6 张。

- 补地照片 2 * 3 = 6 张(水平夹角60度侧补地和收起三脚架垂直补地)。注意挪动三脚架之前放好标记纸牌,拍摄补地照片前收回纸牌。

HDR模式拍摄顺序为正常,过曝光,欠曝光照片。

全景图制作

第一步,基于PTGui拼接全景图;

第二步,基于Krpanno生成浏览器预览VR版本,用手机浏览器在VR眼镜中观看。

PTGui

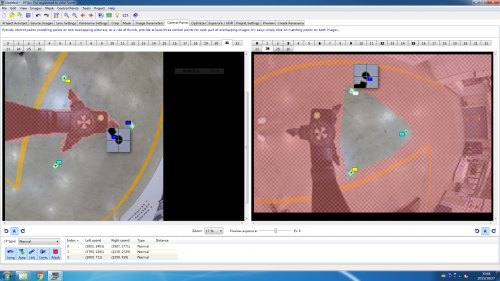

打开PTGui缝合软件,先导入24张HDR模式照片(不含补地照片),缝合后再导入3张侧补地照片,完成导入与link操作后进行mask操作和Control Point对接。可以适当及进行垂直线与白平衡等内容的校正,预览无误后即可导出全景图片。

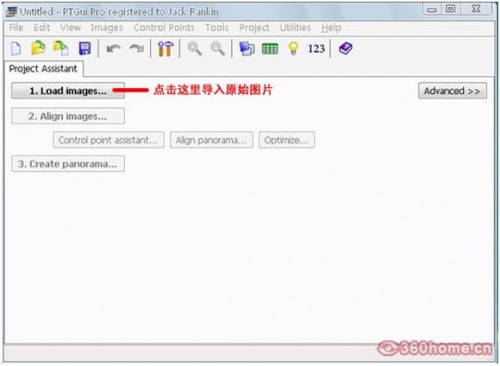

- 导入素材——进入软件页面,点击「Load images...」按钮,导入要合成的一组全景图片,一般为24张,水平每60°一组三张,水平6组,天地各一组,按顺序导入。

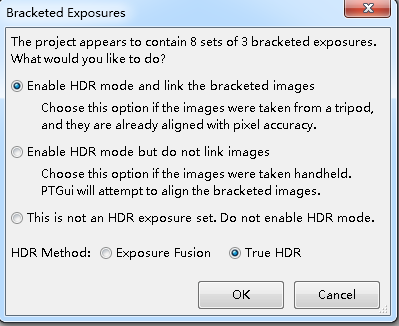

- 对齐图像 选择Align images 按钮,将第一步导入的24个图像对齐拼接为一个全景图, 在弹出对话框中选择第一行

- 添加补地

- 蒙板

- 关键控制点

- 蒙板、优化

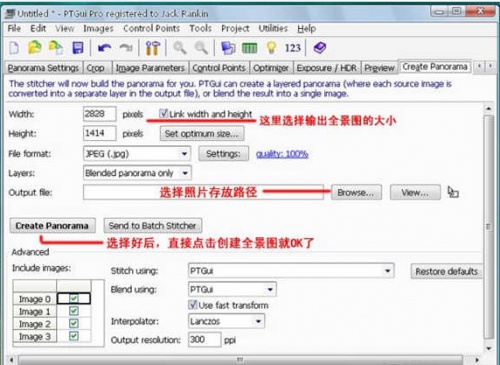

- 生成全景图

- 保存图片

Krpano

Krpano是一个可以方便的将全景图制作成其他形式图片的工具,以.bat批处理的形式提供转换,方法是将要转换的图片,直接拖拽到相应的程序即可。

PANO指的是标准全景; VTOUR是全景漫游; MULTIRES指的是渐进分辨率,没有尺寸及像素限制; NORMAL是生成尺寸最大为2200的标准全景图;

实现特效主要是对vtour文件夹下的html和xml文档通过notepad++进行编程;

具体操作可以参考krpano官网的相关事例教程,添加静态和动态图片视频音频等内容,以及相关互动内容。

需注意手机VR内容需要就陀螺仪控制程序进行相关处理。

通过以上方法生成的文件存放在图片目录下的Vtour目录中,可以将这个目录上传到服务器,放在\\101.6.160.39\vrdemo\ 目录下,并且将默认的文件名tour.html,改名为index.html,就可以通透实验室主页观看你的作品了。

作业上传地址

\\net.icenter.tsinghua.edu.cn\vrdemo 用户名/密码:vr/vr123456

作业浏览地址

http://net.icenter.tsinghua.edu.cn/vr

全景视频VR

全景视频拍摄

摄像器材

高端全景摄像机:

- NEXT VR

- Upano J2VR

- OZO(by Nokia)OZO

- ODYSSEY + JUMP

中低端全景摄像机:

制作软件

Kolor Autopano Video Pro

- 缝合 AUP

- 精调 APG

全景视频拼接

第一步:视频软件拼接

Kolor Autopano Video Pro

- 将不同摄像机中的视频导入软件

- 寻找视频的同步点。(拍摄时候的同步:最常用的如声音同步,或者快速旋转摄像头的图像同步,让拍摄物体短时间同时出现在几个摄像头中)

- 在软件中人工手动寻找声音同步

- 使用Adobe Premiere Pro CC自动寻找同步,把计算出来相差的帧数填入到Kolor Autopano Video Pro中

- 生成有地(三脚架)的拼接视频。

第二步:视频缝合

地面(三脚架)处理软件:Kolor Autopano Giga

该软件用作图片的缝合处理。合理运用下述菜单:

- 自动水平

- 垂直线条工具

- 自动颜色工具

对于地,可以采用PhotoShop擦除三脚架。将PS好的地面截取出来后,导入Kolor Autopano Giga融合。

第三步:生成最后视频

将第二步的输出导入到Kolor Autopano Video Pro,得到合成的视频。

实战拍摄

拍摄分为4组,每组一部摄像机。

分别使用了小蚁的六目相机,detu 4目,完美幻境摄像机。

每人的拍摄时长约为40秒钟。

全景视频剪辑和调色

剪辑

使用Adobe Premiere Pro CC软件进行视频的剪辑,在“序列”(sequence)窗口中导入素材(以及配乐),通过拖拽视频条,可以调整播放的位置,或者两个视频条部分重叠,另在“项目”窗口,选择合适视频过渡效果,比如3D、划像、擦除等,达到两个视频内容叠化效果。

在效果的菜单里,有多种的剪辑方式可选,包括:

- 音频效果

- 音频过渡

- 视频效果

- 视频过渡

- 色调调整

还可以使用小行星的效果。

调色

在Adobe Premiere Pro CC中可以调色,相比较DaVinci Resolve功能更全。

DaVinci包含媒体、编辑、色彩、输出四大功能区。素材导入到媒体池中,在编辑区拖入到时间序列。把时间条移到对应的视频区域,就可以进入色彩菜单进行调整。

- 节点调节

- 一级调色(全局),二级调色(局部)

- 示波器(分量图、直方图、矢量图等)

HTC Vive VR实战

SteamVR

SteamVR是由Valve开发的VR应用平台,可以在Steam中下载。

安装SteamVR后,需要连接HTC Vive设备到PC,完成硬件识别和房间设置后才能使用HTC Vive。

Unity3D技术

(待添加)

在Unity3D中添加HTC Vive支持

其支持是作为一个Assets包引入Unity的,下载地址为: Unity3d assetstore

默认需要在Unity中打开并下载,得到的文件会存放在Unity自己设定的目录中,无法直接获取。具体的位置依系统不同而改变,应当使用搜索引擎获取具体位置。

在Unity项目中导入该Assets,在Unity项目的主视角摄像头上绑定该包提供的Steam_Camera脚本,就可以实现视角和头盔的绑定。这样,一个最简单的VR项目就可以完成了。(手柄的互动等其他高级功能有待添加)

对于Unity没有经验的人可以参考这份文档: 超简Unity3D项目

它提供了一个从「安装Unity」到「建立简单的VR观察者项目」的操作流程

课程分组

学习日志

成果展示

参考文献

The VR Book: Human-Centered Design for Virtual Reality VR Book

Open Source Virtual Reality OSVR